Maschinelles Lernen (ML, engl. Machine Learning) beschreibt Computersysteme, die selbständig in Datensätzen Muster erkennen können, um zielgerichtet Entscheidungen zu treffen. Schon lang bevor ChatGPT und Dall-E viral gingen, fand maschinelles Lernen Einzug in die Finanzmärkte. In dieser Recherche dokumentieren wir den aktuellen Stand der Anwendung an Finanzmärkten.

Im Wertpapierhandel (Trading), der sich historisch bereits sehr früh mit Algorithmen auseinandersetzte, sind die Machine Learning Anwendungen am weitesten fortgeschritten. Käufer und Verkäufer profitieren beide von einer effizienten Preisbildung und Orderabwicklung.

Auch im Risikomanagement zeigen sich erste Anwendungen, die sich allerdings auf geordnete Beschreibungen der Vergangenheit beschränken, ohne daraus Voraussagen für die Zukunft ableiten zu können. Die Fähigkeit von Computern große Mengen an Daten selbstständig zu strukturieren, bringt den entscheidenden Vorteil.

Preisvorhersagen, der heilige Gral des Finanzmarktes, werden mit Hilfe von maschinellem Lernen von diversen Hedge- und auch Publikumsfonds eingesetzt. Große Hedgefondshäuser wie Renaissance Technologies und Bridgewater Associates publizieren die Theorien zu ihren ML-Anwendungen, wenngleich die konkreten profitablen Methoden wie Schätze gehütet werden. Wir meinen zu erkennen, dass sich die Anwender momentan auf kurzfristige Prädiktionen konzentrieren und damit zu Teilen profitable kurzfristig-orientierte Handelsstrategien erstellen können. ML-Ansätze für die Prognose der langfristigen Entwicklung von Einzeltiteln, wie sie genutzt werden könnten, um Portfolios zusammenzustellen, die über einen langen Zeitraum hinweg eine hohe Rendite versprechen, werden unserer Einschätzung nach nicht erfolgreich betrieben.

Maschinelles Lernen gibt den Finanzmarktakteuren ein Werkzeug an die Hand, um Kosten zu reduzieren. Die Prognose zukünftiger Finanzkennzahlen und der Entwicklung von Sektoren über wenige Tage hinaus, ist bisher aber noch Zukunftsmusik für das Feld des maschinellen Lernens und der künstlichen Intelligenz.

Die Entwicklung von der klassischen Statistik zum maschinellen Lernen

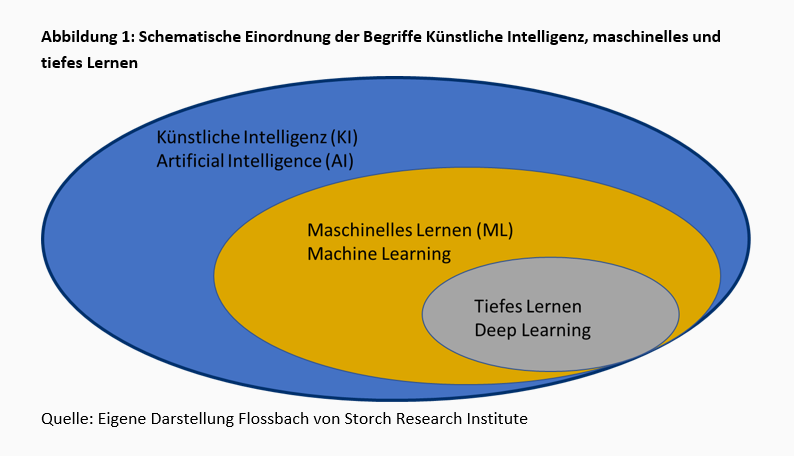

Zu Beginn der Forschung zu künstlicher Intelligenz Anfang der 1950er Jahre, beschränkten sich die praktischen Anwendungen auf Programme, die einfache, standardisierte Berechnungen durchführen konnten und auf normativen Regelsystemen beruhten. Beispielsweise brachte der britische Informatiker Christopher Strachey im Jahr 1951 einem Computer die Regeln für das Brettspiel Dame bei. Bereits ein Jahr später wurde von Anthony Oettinger an der Universität Cambridge ein erstes selbstlernendes Programm vorgestellt: „Shopper“ konnte in einer Modellwelt von acht Geschäften einkaufen. Beim ersten Einkauf durchlief das Programm die Geschäfte zufällig, merkte sich aber zum Teil in welchem Geschäft welche Artikel lagerten. Sollte „Shopper“ anschließend einen Artikel besorgen, den er sich gemerkt hatte, ginge er direkt in das richtige Geschäft. Damit war das heute dominierende Teilgebiet künstlicher Intelligenz (KI), das maschinelle Lernen, geboren.

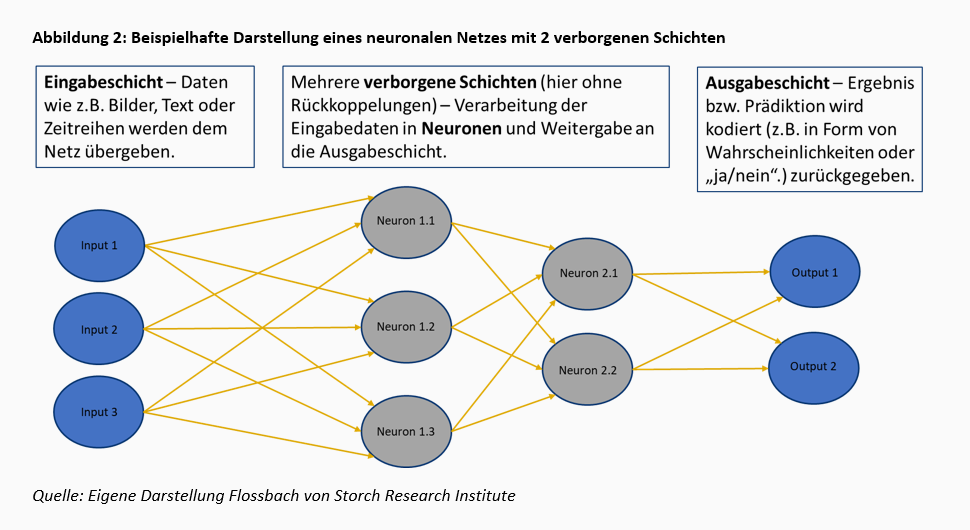

1989 machte maschinelles Lernen den nächsten Sprung. Yann LeCun programmierte einen Algorithmus, der mit Hilfe eines sogenannten neuronalen Netzes die Ziffern auf handgeschriebenen Schecks unterscheiden konnte. Das System betrachtete bereits klassifizierte Ziffern, analysierte die Pixelstruktur und entwickelt daraufhin selbstständig eine Struktur, um später unbekannte Ziffern zu klassifizieren. Vorgegeben waren nur noch Input und Output sowie die Methode „neuronales Netz“. Dieses heute sehr populäre Teilgebiet von ML wird daher als Tiefes Lernen bezeichnet.

In weitergehenden Formen des Tiefen Lernens gibt man den Modellen zusätzliche Freiheit über den Output. Im Jahr 2012 fütterte Google im sogenannten „Cat Experiment“ ein neuronales Netz mit zehn Millionen zufällig ausgewählten Bildern unter der allgemein gehaltenen Vorgabe, wiederkehrende Muster zu erkennen. Es entstand ein System, das unter anderem Katzen und menschliche Gesichter erkannte.1

Prädiktion wirtschaftlicher Kennziffern durch maschinelles Lernen – die Grundidee

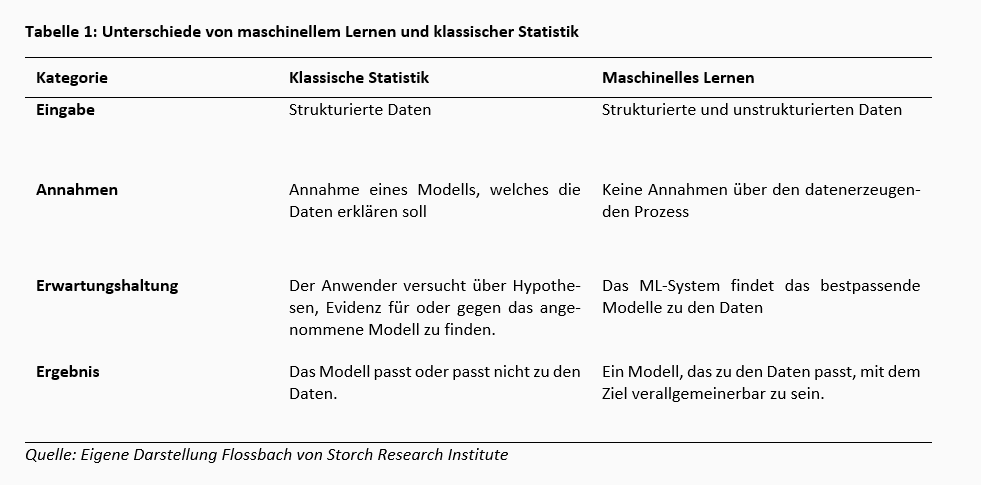

Anstatt wie in der klassischen Statistik zum Beispiel mit Regression auf Basis eines vorgegebenen Modells den künftigen Kurs einer Aktie auf Basis zu schätzen, werden beim maschinellen Lernen große Datenmengen nach Mustern durchforstet. In der Regel werden vorab keine ökonomischen Annahmen getroffen. Man kann sich dies wie eine Tanzfläche mit tausenden von Tanzpaaren vorstellen, auf der man die Trajektorie eines einzelnen Paares voraussagen will, während sich alle Paare gegenseitig beeinflussen. Es ist schwer vorstellbar, dies durch ein im Voraus definiertes mathematisches Modell abbilden zu können. Idealerweise stößt die Maschine auf Zusammenhänge, die dem menschlichen Auge verborgen bleiben. Computer profitieren dabei davon eine ungleich größere Datenmenge in gleicher Zeit verarbeiten zu können als der Mensch und nicht unter psychologischen Effekten wie kognitiven Verzerrungen leiden.

Eine tabellarische Gegenüberstellung der wichtigsten konzeptionellen Unterschiede des klassischen statistischen Ansatzes gegen den des maschinellen Lernens haben wir in Tabelle 1 zusammengefasst. Weitere Details findet man in der Literatur.2

Von der Mustererkennung zur computerbasierten Handlung

Eine Anleitung, wie eine Wertschöpfungskette zum Erstellen und Anwenden maschinellen Lernens an Finanzmärkten aussehen kann, wird von dem ehemaligen Hedgefonds Manager Marcos López de Prado beschrieben.3

Zu Beginn der Wertschöpfungskette steht das Sammeln, Bereinigen, Indizieren, Anpassen und Speichern von Informationen. Die Informationen können aus den verschiedensten Quellen entstammen und sind nicht nur auf Finanzmarktdaten und Unternehmensinformationen beschränkt. Sie können strukturiert oder unstrukturiert sein, als Text, in Zahlen oder sogar Videos vorliegen. Die Qualität der erhobenen Informationen ist entscheidend für den Erfolg der darauf aufbauenden Prozesse, denn das Resultat kann nicht besser sein als der Informationsgehalt der Daten.

In einem zweiten Schritt erfolgt der Einsatz von ML, um in den Rohdaten Muster zu erkennen, welche in Zusammenhang mit Finanzkennzahlen stehen. Als Drittes bekommen Strategen die Aufgabe, Aktionen basierend auf den identifizierten Mustern zu formulieren. Dabei stehen die Strategen vor der Aufgabe, zu den Mustern Thesen zu formulieren, welche die ökonomischen Vorgänge erklären können. Dies soll sicherzustellen, dass es sich nicht um einen zufälligen, nicht kausal begründbaren Fund handelt. Rückblickend soll das erkannte Muster als Test für die Thesen angesehen werden. Aus der „Black Box“ des gefunden Musters soll einen verstandene „White Box“ werden. Im vierten Schritt werden die Aktionen mittels Backtesting auf die Probe gestellt. Nur weil in der Vergangenheit ein Muster erfolgreich ausgenutzt werden konnte, muss dies nicht bedeuten, dass dies in der Zukunft ebenso der Fall sein wird. Hierfür können unterschiedliche Zeitabschnitte genutzt oder Daten selbst simuliert werden.

Nach erfolgreichem Backtest geht es an die Umsetzung. Die Aktion muss als fünfter Schritt in die bestehenden Systeme und Prozesse eingebunden und sichergestellt werden, dass zwischen dem Erkennen von Mustern und der Aktion kein Zeitverzug entsteht, der die Handlung obsolet machen würde.

Verlief die technische Umsetzung erfolgreich, so kann die Aktion in den Betriebsprozess aufgenommen werden. Der Erfolg, das Risiko und die Kosten der ML-basierten Aktion müssen stetig überwacht werden. Denn früher oder später kann es dazu kommen, dass sich die Muster in den Daten verändert haben und nicht mehr ausgenutzt werden können, da beispielsweise andere auf das Muster aufmerksam geworden sind und es ebenfalls versuchen auszunutzen. Die Entwicklung und Umsetzung von Mustererkennung und darauffolgenden Aktionen müssen permanent erfolgen, damit ausrangierte Aktionen ersetzt werden kann und man sich stets an veränderten Rahmenbedingen anpassen kann.

Funktionierende Ansätze zur Mustererkennung stellen das „Herz“ der Wertschöpfungskette dar und müssen dem entsprechend geschützt werden, um den kompetitiven Vorteil zu bewahren. Im Gegensatz dazu sind die grundlegenden Methoden kein Betriebsgeheimnis und als frei verfügbare Versionen im Internet zu haben. Beispielsweise erzeugt eine Suche auf dem Onlineportal für Open Source Programme github.com nach dem Begriff „stock price prediction“ 854 Ergebnisse.4 Wie gut diese öffentlich verfügbaren Ansätze wiederum sind, sei damit nicht gesagt.

Nach dieser theoretischen Einführung beleuchten wir im Folgenden praktische Umsetzungen.

Was über die praktische Anwendung von KI in der Finanzwirtschaft bekannt ist.

Als die bekanntesten Pioniere im praktischen Einsatz von Algorithmen in der Finanzwirtschaft kann man den Mathematiker Jim Simons und seine Firma Renaissance Technologies sowie Ray Dalio, den Gründer von Bridgewater Associates, bezeichnen. Beide versuchten bereits in den 80er-Jahren mit Hilfe von Computern den Wertpapierhandel zu formalisieren und Entscheidungen zu automatisieren. Sie sind davon überzeugt, dass Finanzmärkte bestimmten Mustern folgen. Simons begann mit „Mean-reverting“ und Trendfolge-Algorithmen.5 Heute sind, seiner Aussage nach, jedoch verfeinerte Methoden notwendig. Der Anlagehorizont ist dabei stets „short-term“. Seine Positionen hält er maximal zwei Wochen.6

Ray Dalio begann ebenfalls früh mit der mathematischen Formalisierung ökonomischer Zusammenhänge. Er beschreibt die Wirtschaft oft als „economic machine“. Seiner Ansicht nach ist sie ein riesiges Geflecht aus Zusammenhängen von Ursache und Wirkung, und gleicht einer Maschine ineinandergreifender Zahnräder. Die von ihm gegründete Firma Bridgewater strebt danach, diese Zusammenhänge möglichst exakt nachzubilden und zu verfeinern. Sein erstes Modell zum Bondmarkt passte dabei noch auf eine DIN A5 Seite.7

Was wirkt aktuell gemacht?

Wo aber stehen diese und andere Firmen heute? Laut Greg Jensen, Co-CIO von Bridgewater, ist das Ziel von Bridgewater nach wie vor jegliche Entscheidungen in Algorithmen abzubilden und zu automatisieren.8 Die Angestellten konzentrieren sich auf die Weiterentwicklung der Modelle. Durch das Hinzufügen neuer Daten und Inputparameter werden die Prognosemethoden verfeinert, plausibilisiert und getestet bevor sie den Korpus bestehender Algorithmen im „echten“ Betrieb erweitern. Bei den verwendeten Methoden spielt auch maschinelles Lernen eine Rolle. Die Ergebnisse schildert Jenson wie folgt:

- Bei Aufgaben, zu denen es viele Daten gibt, welche repräsentativ für das aktuelle Problem sind, erzielt man mit maschinellem Lernen sehr gute Ergebnisse. Er nennt als Beispiel die Senkung von Transaktionskosten, also Anwendungen im Trading.

- Maschinelles Lernen wird darüber hinaus als „hint machine“, also als Hinweisgeber, eingesetzt. Es hilft Bridgewater Widersprüche und Verbesserungspotentiale in ihren Algorithmen zu entdecken.9

- Experimentiert wird noch mit Situationen und Entscheidungsproblemen, bei denen die vorhandenen Daten nicht in ausreichender Menge repräsentativ sind. So bestehen Probleme den Einfluss von maschinellem Lernen selbst zu quantifizieren, da dies eine Entwicklung jüngerer Zeit ist. Auch die Fiskalpolitik der vergangenen Jahre lässt sich kaum mit anderen historischen Mustern abgleichen.

Jensen widerspricht vehement dem Argument, das maschinelles Lernen für Menschen eine „Black Box“ sei. Im Entwicklungsprozess neuer Modelle, der wie oben beschrieben stets vom Menschen überwacht wird, würden bei der Software bei Bridgewater verschiedene Fragen gestellt, um ihr Verhalten zu verstehen. Übersetzt bedeutet dies wohl ein Experimentieren mit verschiedenen Eingabeparameter und der Interpretation der Ergebnisse. Interessant ist die Analogie zu menschlicher Interaktion, die Jensen zieht: Warum ein Mensch auf eine bestimmte Frage eine bestimmte Antwort gibt, lässt sich oft nicht erklären. Im Laufe eines Gesprächs erhält man durch mehrere Antworten auf verschiedene Fragen aber eine Idee der Beweggründe des Einzelnen. Man versteht seine Handlungslogik.

Für Jensen ist maschinelles Lernen eine Evolution der Algorithmik. Es räumt dem Nutzer bei konkreten Handelsentscheidungen Vorteile ein. Für ein Erkennen von langfristigen Entwicklungen fehlt offenbar noch das Vertrauen in ML. Wir werden nun konkrete Beispiele aus der Finanzwirtschaft benennen und orientieren uns dabei an der von Jensen berichteten Hierarchie. Wir beginnen mit Trading und Transaktionskosten, gehen zu Risikomanagement-Tools über und schließen mit (langfristigen) Prädiktionen und deren Herausforderungen.

Transaktionskostenkontrolle im Trading nutzt ML

Greg Jensens Aussage, dass ML im Trading bereits erprobt ist, erscheint uns plausibel. Einer aktuellen Umfrage zufolge handeln 57 Prozent der Teilnehmer mehr als 50 Prozent ihres Volumens per Algorithmen.10 Schätzungen aus dem Jahr 2018 gehen davon aus, dass 60 bis 75 Prozent des Volumens auf dem amerikanischen Aktienmarkt algorithmisch gehandelt wird.11 Unternehmen, welche Dienste in diesem Bereich anbieten, finden sich einige. Vieles deutet daher daraufhin, dass dieser Bereich in Sachen ML am weitesten fortgeschritten ist. Einer der Gründe ist vermutlich ein gemeinsames Interesse aller Marktteilnehmer: die Reduktion von Transaktionskosten durch einen ausreichend liquiden Markt. Da jeder Marktteilnehmer als Käufer und Verkäufer auftritt, profitieren alle von verlässlichen Preisen beziehungsweise kalkulierbaren Spreads.

JP Morgan nennt in einer Veröffentlichung zum Stand der Forschung von ML beispielsweise die Firma Deltix als Spezialanbieter für Trading-Software.12 Deltix selbst hält sich mit der Verwendung des Begriffs ML zwar zurück, Top-Manager Stuart Farr spricht in einem Artikel aus dem Jahr 2017 von adaptiven Algorithmen, die Echtzeitdaten verwenden, als dem heiligen Gral der Orderausführungsalgorithmen.

Jeff Bacidore, ehemals Head of Algorithmic Trading bei Goldman Sachs, gibt auf der Website seines eigenen Unternehmens Bacidore LLC detailliertere Einblicke in Gründe und Methoden: Im Gegensatz zu den eigentlichen Kursbewegungen sind die täglichen Muster der gehandelten Volumina sowie von Volatilität und Spreads beständiger. Die Muster verändern sich nur langsam über die Zeit. Die gehandelten Volumina innerhalb eines Handelstages in den USA haben beispielsweise die Form eines „J“. Die Spreads folgen einem auf die Seite gelegten, verzerrten „S“.13 Trading so führt Bacidore weiter aus, war traditionell von statistischen Methoden getrieben. Nun eröffnen die täglich entstehenden enormen Mengen an Daten und die steigende Leistungsfähigkeit von Computer Möglichkeiten für das maschinelle Lernen.14

Als ein Beispiel nennt Bacidore die Weiterentwicklung der Volume-Weighted-Average-Price-Strategie. Große Orders werden hier in Teilpakete aufgeteilt, um den Kurs nicht durch die eigenen Handlungen negativ zu beeinflussen. Aktien werden dabei aufgrund ihrer Eigenschaften wie Zugehörigkeit zu einem Index oder dem täglichen Handelsvolumen in verschiedene „Buckets“ eingruppiert. Für jedes „Bucket“ wird dann ein Handelsschema erstellt, d.h. festgelegt welche Größe die Teilpakete haben und zu welchen Zeitpunkten sie am Markt platziert werden. Dies erfordert viel manuelle Arbeit. Mit Hilfe von „k-means“-Algorithmen lässt sich dieser Prozess automatisieren. Basierend auf vorgegebenen Eingangsvariablen gruppiert der Algorithmus die verschiedenen Aktien anhand ihrer Ähnlichkeit in Handelsstrategien, die er selbst bestimmt. Lediglich die Zahl der Cluster wählt der Mensch noch selbst, wobei auch hierfür bereits quantitative Hilfsmittel angegeben werden.

Der Algorithmus kann auch dafür verwendet werden, die in einem Unternehmen angewendeten Handelsstrategien zu klassifizieren. So entsteht eine Übersicht über das Trading-Verhalten eines Finanzakteurs. Wir würden dies dem Risikomanagement zuordnen, welches wir später mit weiteren Beispielen ausleuchten.

Der Broker Tullet Prebon geht auf Einkaufstour

Ein weiteres Indiz für den weit fortgeschrittenen Einsatz von ML im Trading ist die Akquisition von Liquidnet, einem auf ML-Trading spezialisierten Anbieter, durch Tullet Prebon, einem der größten Inter-Banken Broker der Welt.15 Die Produkte von Liquidnet werden weltweit in 46 Märkten, darunter den USA und China, eingesetzt. Liquidnet hatte selbst im Jahr 2019 seine KI-Aktivitäten durch die Akquisition von Prattle ausgeweitet.16 Prattle war ein Spezialist auf dem Gebiet des Natural Language Processing, also dem Auslesen von Texten durch Maschinen und der Sentiment-Analyse.

Für Liquidnet war die Akquistion von Prattle die letzte in einer Reihe von mehreren Zukäufen. Das Endprodukt war ein Software-Modul namens Investment Analytics, das sich KI-Methoden bedient und neben klassischer Trading-Unterstützung weitere Funktionen bündelt.17 Der Kauf durch Tullet Prebon ist ein klares Indiz dafür, dass Trading-Unterstützung den Kinderschuhen entwachsen ist und der Markt sich konsolidiert, wobei etablierte Häuser Technologie zukaufen.

Zusätzlich sieht man weitere etablierte Finanzdienstleister Software-Lösungen im Bereich Trading anbieten. Exemplarisch seien hier Citigroup18 und die Royal Bank of Canada (RBC) genannt.19 Die RBC verwendet hierfür sogenanntes „Reinforced Learning“. Die verwendeten Algorithmen passen sich aufgrund des Feedbacks aus getätigten Transaktionen selbstständig an und reagieren damit dynamisch auf neue Situationen.

Der japanische Pensionsfonds als Dachfonds bringt Ordnung in sein Portfolio

Seit 2017 hat sich der Japan’s Government Investment Fund (GPIF), der größte Pensionsfonds der Welt, unter seinem CIO Hiromichi Mizuno in einer Partnerschaft mit den Sony Computer Science Laboratories dem Thema ML im Risikomanagement angenommen. Mizuno ist von den Möglichkeiten von KI überzeugt. In seinen Worten klingt das so:

“We're just trying to prove, even the boring organizations like the GPIF can benefit from AI to send a message (that) the industry should be able to benefit much more from AI adaption."20

GPIF investiert Teile seiner Kundengelder nicht selbst, sondern in aktiv gemanagte Fonds.21 Die Ergebnisse der (Aktien‑) Fonds wurden allerdings als enttäuschend betrachtet. Daher versuchen GPIF und Sony den Auswahl- und Monitoring-Prozess mit Hilfe von ML zu verbessern. Im ersten Schritt wurden acht Investmentstile definiert. Der Stil „High Dividend“ steht beispielsweise für eine Strategie, die Aktien mit hoher historischer Dividende bevorzugt. Weitere Strategien waren „Minimum Volatility“, „Momentum“, „Value“, „Growth“, „Quality“, „Fixed Weight“ und „Technical“.22 Danach wurden virtuelle Fonds erstellt, die sich an diesen Strategien ausrichten, um ein neuronales Netz trainieren zu können.

Zum eigentlichen Training wurden dann 19 Faktoren, wie Preis einer Aktie und Dividende aber auch Marktdaten und fondspezifische Daten, über einen rollierenden Zeithorizont von 40 Tagen auf 100 Aktien betrachtet. Aus diesen 76.000 Inputs entstanden so acht neuronale Netze, welche als Output angeben zu wieviel Prozent ein Fonds einen der acht Stile verfolgt. Es entstand eine Maschine, die die virtuellen Fonds korrekt den Investmentstilen zuordnete.23 Der Algorithmus analysierte anschließend die Stile aktiv gemanagter Fonds, in die GPIF investiert ist. Neben Fonds, die „ihrer Linie treu“ geblieben sind, bildete das Modell in einem Fall auch den Wechsel vom „Momentum“ zum „Growth“-Stil ab. Zeitlich fiel dies mit Personalwechseln im Fonds-Management zusammen.

Im Rahmen der weiteren Forschung wurden die Einflussfaktoren für die Unterschiede verschiedener Fonds analysiert. Im Vergleich eines im Portfolio befindlichen Fonds und eines „Kandidaten“-Fonds bestätigte die Software die auch durch klassische Analyse gefundene Präferenz für einen Industriesektor und einen bestimmten Einzeltitel als Hauptunterschied der beiden Fonds. Zusätzlich zu dieser Bestätigung lieferte der Algorithmus Visualisierungen der Risikopositionen aller gehaltenen Fonds, was die Übersichtlichkeit über das Portfolio erhöht.24

Die weitere Forschung beschäftigt sich mit der Prognose der Risikostruktur der Fonds, wenn sich die wirtschaftlichen Rahmenbedingungen ändern. Insbesondere wird erforscht, ob sich Umschichtungen in einzelnen Fondsportfolios voraussagen lassen und was dies für die Risikoposition des Fonds bedeutet. Damit geht man über einen statischen Stresstest hinaus, da man nicht nur die wirtschaftlichen Parameter ändert, sondern auch versucht die Reaktionen darauf vorherzusagen. Die Ergebnisse sind noch nicht veröffentlicht.

TwoSigma Regime Analysis – keine Vorhersage, aber selbstgefundene Szenarien

Eine weitere Anwendung für das Risikomanagement zeigt das amerikanische Hedgefonds-Haus TwoSigma Investments unter dem Begriff Regime Modeling.25 Ziel war die Klassifizierung der Vergangenheit seit 1970 in verschiedene makroökonomische Zustände. Basierend auf 17 Faktoren war es dem Algorithmus freigestellt die Zahl der unterschiedlichen Regime selbstständig zu bestimmen. Zur Anwendung kam ein sogenanntes Gaussian-Mixture-Model, welches ohne menschliche Vorgaben lernt und durch die Kombination mehrerer Normalverteilungen auch Tail-Risiken abbilden kann.

Das Modell teilte die Vergangenheit in vier Zustände ein – zu jedem Zustand gehört eine 17-dimensionale Normalverteilung inklusive der Mittelwerte, Varianzen und Kovarianzen zwischen den Einflussfaktoren. Es verwendete dabei keine Theorien und gab den Szenarien auch keine Namen. Die Forscher von TwoSigma benannten die Szenarien nachträglich auf Basis ihrer eigenen Assoziationen. Sie entschieden sich für die sprechenden Namen „Crisis“, „Steady State“, „Inflation“ und „Walking on Ice“, wobei dem Laufen auf Eis nicht notwendigerweise ein krisenhafter Einbruch folgen muss, sondern nur eine durch Unsicherheit geprägte Phase gemeint ist. Manchmal erreicht man das andere Ufer auch trockenen Fußes und man setzt den Weg auf stabilem Untergrund fort.

Auch in diesem Modell ist keine Prädiktion möglich. Aber zum Risikomanagement taugt das Ergebnis dennoch: Glaubt man daran, dass der Algorithmus die „wesentlichen“ vier makroökonomischen Zustände gefunden hat, kann man zwar nicht voraussagen welches Szenario als nächstes eintritt, aber sich so positionieren, dass das eigene Portfolio unter jedem der vier Szenarien eine robuste Performance zeigt. In jedem Fall regt es zum Nachdenken über makroökonomische Sachverhalte an, wirkt also als die von Greg Jensen angesprochene „hint machine“.

Kurzfristige Prädiktion ist schon länger ein Hot Topic

In der kurzfristigen Prädiktion von Kursen setzt das Renaissance Technologies bereits seit längerem Machine Learning ein, wie Simons in einem Interview erklärt.26 Seinen eigenen Angaben zu Folge erzielte das Flaggschiff von Renaissance, der Medaillon Fonds, damit eine durchschnittliche Rendite von 44 Prozent pro Jahr.27 Bei den verwendeten Methoden handelt es sich um weiterentwickelte Trading-Algorithmen, welche auf Basis langjährig zusammengesammelter Daten mit einer gewissen Wahrscheinlichkeit Auffälligkeiten identifizieren kann. Einzelne Positionen werden maximal ein bis zwei Wochen gehalten.28 Die Höhe der Wetten wird vermutlich nach dem Kelly-Kriterium bestimmt, einer mathematischen Formel welche abhängig von den geschätzten Gewinnchancen und dem zu erwartenden Gewinn vorgibt, wieviel Kapital ein Investor einsetzen sollte.29 In jedem Fall werden die Entscheidungen alle vollständig von der Maschine getroffen. Kein Mensch greift nach Aussagen von Simons aufgrund seines Bauchgefühls in den Vorgang ein, auch wenn der Mensch damit auch mal im Recht sein könnte, wie Simons einräumt. Ihm geht es aber um den Kasino-Effekt: der Algorithmus muss, gewichtet nach dem eingesetzten Kapital nur öfter richtig als falsch liegen – dann gewinnt der Fonds an Wert.

Der Erfolg des Medaillon Fonds wird von Warren Buffet und Charlie Munger bestätigt.30 Sie weisen jedoch auch daraufhin, dass die Methoden nur funktionieren, solange man das Volumen innerhalb eines bestimmten Rahmens hält, da die Anomalien sonst von den eigenen Handelsaktivitäten „aufgefressen“ werden – ein Argument, dass auch Simons benennt. Zusätzlich weisen Buffet und Munger daraufhin, dass die Algorithmen beim langfristigen Investieren nicht in gleichem Maße überzeugen, was durch die Performance, des langfristig orientierten Publikumsfonds von Renaissance bestätigt wird.31 Die Antwort Buffets auf die Frage, ob er und Munger einen Datenwissenschaftler für „Short-term“ Trading einstellen würden zeigt die Wertschätzung für Simons Arbeit, aber auch ihre eigene Haltung:

“We do not know how to do it and we do not really trust anybody else to trade for us.”32

Die oben beschriebenen Beispiele zeigen, dass kurzfristige Prädiktion durch ML sehr erfolgreich sein kann. Es ist auch nicht auszuschließen, dass weitere, hier nicht genannte Firmen unterhalb des Radars ähnliche Strategien mit Erfolg verwenden. Aufgrund der Beeinflussung des Marktes durch das eigene Handeln ist anzunehmen, dass sie diskret vorgehen und mit vergleichsweise kleinen Volumina handeln.

Dies wiederum zeigt die heutigen Grenzen der Algorithmen auf. Entstehende Kosten können nicht durch höheren Kapitaleinsatz ausgeglichen werden. Der Medaillon Fond ist zehn Milliarden Dollar groß und erwirtschaftet damit jährlich im Durchschnitt 4,4 Milliarden US-Dollar Gewinn. Zum Vergleich: Berkshire Hathaway hatte 2017 ein Börsenwert von circa 350 Milliarden Dollar, der sich seitdem fast verdoppelt hat. Wer also genug Vertrauen in Buffet und Munger hatte, hätte durch fremdkapitalfinanziertes Investieren in Berkshire je nach Risikoappetit durch Hebeln höhere Renditen erwirtschaften können.

Um mit KI zukünftig auch größere Volumina handeln zu können, ist daher eine mögliche Strategie Algorithmen zu finden, die langfristige Prädiktionen erlauben. Der nächste Abschnitt beleuchtet einige bestehende Produkte dieser Art.

In der langfristigen Portfoliosteuerung versagt KI bisher

Versuche über maschinelles Lernen Aktien zu identifizieren und ein rentables Portfolio zu erstellen, haben auch die Branche der Publikumsfonds erreicht. Produkte hierzu finden sich beispielsweise bei AIEQ, ACATIS, DWS oder Ampega.33 ML wird hierbei eingesetzt, um die Fondsmanager bei der Datenauswertung zu unterstützen oder auch um aktive Entscheidungen zu treffen. Der bereits 2017 aufgelegte AIEQ Funds, der Mittels IBM Watson Investitionsziele identifiziert und sein Portfolio allokiert, schloss sein Fiskaljahr 2022 mit einem Verlust von knapp 30 Prozent ab, während der S&P 500 Index im gleichen Zeitraum lediglich 15 Prozent verlor.24 Eine 2022 veröffentlichten Studie kontestiert basierend auf einem Vergleich von passiven, aktiven und KI-basierten Investmentfonds, dass KI-basierte Investmentfonds grundsätzliche keine höhere Preisvorhersagekraft vorweisen und dass sich ihre risikoadjustierten erwirtschafteten Renditen nicht von den Vergleichsgruppen absetzen können.35

Es gibt sogar Stimmen, die langfristige Prädiktion grundsätzlich für einen wenig erfolgsversprechenden Weg halten und unter dem Begriff „More Nowcasting – Less Forecasting“ eine Fokussierung auf kurzfristige Prognosen befürworten.26 Um hohe Volumina handeln zu können, müssten die Algorithmen dann aber bedeutendere Auffälligkeiten entdecken können. Als Beispiel dafür, dass dies grundsätzlich möglich ist, wird vom oben bereits erwähnten ehemaligen Hedgefonds Manager Marcos López de Prado der 30-prozentige Kurssturz des S&P 500 im Frühjahr zu Beginn der Corona-Pandemie genannt. So hätten sehr wenige „Market Maker“ damals Verluste erzielt, da sie durch Ungleichgewichte von Angebot und Nachfrage in den Orderbüchern, frühzeitig vor dem kommenden Kursrutsch gewarnt worden seien. Zusätzlich wird angeführt, dass dem Abrutschen der Börsenkurse mit ungefähr vier Wochen Vorlauf aufgrund der ersten Lockdowns in China ein ebenso heftiger und plötzlicher Verfall einiger Rohstoffpreise vorangegangen sei. Offen bleibt, ob dieser Zusammenhang Rückschlüsse auf Muster von Preisschocks im Allgemeinen erlaubt oder ein im Nachhinein plausibilisiertes Einzelphänomen bleibt.

Auch wenn einem stets bewusst sein muss, dass die Machine Learning Methoden diverser Hedgefonds nicht veröffentlicht werden und besonders dann geheim gehalten werden, wenn sie erfolgreich sind, so ist dennoch davon auszugehen, dass früher oder später zumindest die Information, dass ein Fondshaus mit dem langfristigen ML-basierten Stock Picking erfolgreich ist, bekannt werden würden. Wie diese Diskussion auch immer ausgeht, unterm Strich sind uns Stand heute keine Algorithmen bekannt, welche langfristig profitabel beispielsweise Narrativwechsel oder Regimewechsel im Sinne der Discovering Market Hypothesis von Kleinheyer und Mayer vorhersagen können37 und somit echte Vorteile in der langfristigen Prädiktion oder der Voraussage von fundamentalen Strukturbrüchen bieten.

Fazit

Durch die Veröffentlichung von Chat-GPT ist die Welt auf die neusten Fähigkeiten der künstlichen Intelligenz aufmerksam geworden, obwohl Ansätze wie maschinelles Lernen bereits seit Längerem an den Finanzmärkten angewendet werden.

Unserer Einschätzung nach wird es zukünftig weitere Effizienzgewinne über das Reduzieren von Transaktionskosten und effiziente Risikowarnsysteme hinaus geben. Auch wenn manche ML-Ansätze bereits jetzt in der Lage sind, kurzfristige Preisbewegungen zu antizipieren, bleibt fraglich, ob Algorithmen jemals die langfristigen Preisbewegungen an den Kapitalmärkten antizipieren können. Ob Maschinen versierte Investoren wie Warren Buffet und Charlie Munger überflügeln werden, bleibt abzuwarten. Als überaus hilfreiche technische Unterstützung dienen diese jedoch bereits heute. Wer nicht von der Entwicklung abgehängt werden möchte, der sollte an diesem Thema dranbleiben und die nächsten Schritte aufmerksam verfolgen oder besser gar selbst gestalten.

________________________________________________________

1 A Brief History of Deep Learning - DATAVERSITY

2 Mueller & Massaron: “Machine Learning for dummies”, 2nd ed., Tab. 1-1

3 Marcos Lopez de Prado: „Advances in Financial Machine Learning”, John Wiley & Sons, New Jersey, 2018.

4 Siehe github.com, abgerufen am 24.02.2023.

5 The mathematician who cracked Wall Street | Jim Simons - YouTube

6 Renaissance Technologies - Trading Strategies Revealed | A Documentary - YouTube und Renaissance Technologies - Wikipedia

7 Greg Jensen on Algorithmic Decision Making and Artificial Intelligence (bridgewater.com), Screenshot des Originals Laufzeit 4:30.

8 Greg Jensen on Algorithmic Decision Making and Artificial Intelligence (bridgewater.com)

9 Greg Jensen on Algorithmic Decision Making and Artificial Intelligence (bridgewater.com), Laufzeit 14:50.

10 Algorithmic-Trading-Survey-Long-Only-2022.pdf (thetradenews.com)

12 JPM-2017-MachineLearningInvestments.pdf (cpb-us-e2.wpmucdn.com)

13 Investing in Trader Alpha: A reliable, cost-effective way to boost performance (bacidore.com)

14 Applications of Machine Learning in Trading: Part 1 (bacidore.com)

17 Liquidnet Investment Analytics

19 From Artificial Intelligence to Trading Intelligence (rbccm.com)

20CIO of Japan's GPIF praises AI technology | Pensions & Investments (pionline.com)

21 GPIF Annual Report 2021, S. 89.

23 GPIF / Sony CSL (2018), Abb. 2.3.

24 GPIF / Sony CSL (2020), Abb. 1.

25 Machine-Learning-Approach-to-Regime-Modeling_.pdf (twosigma.com)

26 James Simons (full length interview) - Numberphile - YouTube

27 The mathematician who cracked Wall Street | Jim Simons - YouTube

28 Medallion Fund Literally Printed Money in the Last 30 Years | Wealth of Geeks

29 Renaissance Technologies - Trading Strategies Revealed | A Documentary - YouTube und Kelly-Formel – Wikipedia

30 Warren Buffett & Charlie Munger On Jim Simons & Quant Investing - YouTube

31 Renaissance U.S. Equity Income Fund | Renaissance Investments

32 Warren Buffett & Charlie Munger On Jim Simons & Quant Investing - YouTube

33 Bspw. AIEQ AI Powered Equity ETF, Acatis AI Global Equities, LI Data Intelligence Germany, DWS Concept ESG Arabesque AI Global Equity.

34 AIEQ: Shareholder Letter 2022

36 Lopez de Prado, Lipton (2020): “Three Quant Lessons from COVID-19), SSRN.

Glossar

Verschiedene Fachbegriffe aus der Welt der Finanzen finden Sie in unserem Glossar erklärt.

RECHTLICHER HINWEIS

Diese Veröffentlichung dient unter anderem als Werbemitteilung.

Die in dieser Veröffentlichung enthaltenen Informationen und zum Ausdruck gebrachten Meinungen geben die Einschätzungen von Flossbach von Storch zum Zeitpunkt der Veröffentlichung wieder und können sich jederzeit ohne vorherige Ankündigung ändern. Angaben zu in die Zukunft gerichteten Aussagen spiegeln die Zukunftserwartung von Flossbach von Storch wider, können aber erheblich von den tatsächlichen Entwicklungen und Ergebnissen abweichen. Für die Richtigkeit und Vollständigkeit kann keine Gewähr übernommen werden. Der Wert jedes Investments kann sinken oder steigen und Sie erhalten möglicherweise nicht den investierten Geldbetrag zurück.

Mit dieser Veröffentlichung wird kein Angebot zum Verkauf, Kauf oder zur Zeichnung von Wertpapieren oder sonstigen Titeln unterbreitet. Die enthaltenen Informationen und Einschätzungen stellen keine Anlageberatung oder sonstige Empfehlung dar. Sie ersetzen unter anderem keine individuelle Anlageberatung.

Diese Veröffentlichung unterliegt urheber-, marken- und gewerblichen Schutzrechten. Eine Vervielfältigung, Verbreitung, Bereithaltung zum Abruf oder Online-Zugänglichmachung (Übernahme in andere Webseite) der Veröffentlichung ganz oder teilweise, in veränderter oder unveränderter Form ist nur nach vorheriger schriftlicher Zustimmung von Flossbach von Storch zulässig.

Angaben zu historischen Wertentwicklungen sind kein Indikator für zukünftige Wertentwicklungen.

© 2025 Flossbach von Storch. Alle Rechte vorbehalten.